With the rapid progress of the field, further scaling of RL for LRMs now faces foundational challenges not only in computational resources but also in algorithm design, training data, and infrastructure. To this end, it is timely to revisit the development of this domain, reassess its trajectory, and explore strategies to enhance the scalability of RL toward Artificial SuperIntelligence (ASI).

Introduction

从 AlphaGo 到大模型对齐 (Human Alignment)

强化学习在传统领域已经取得了巨大成功,比如 AlphaGo 和 AlphaZero 项目,[cite: 73],它们就是通过强化学习中的“自我对弈”(self-play)和奖励反馈机制,在围棋这项复杂的任务上超越了人类世界冠军 [cite: 73],这证明了 RL 在解决复杂问题上的巨大潜力。

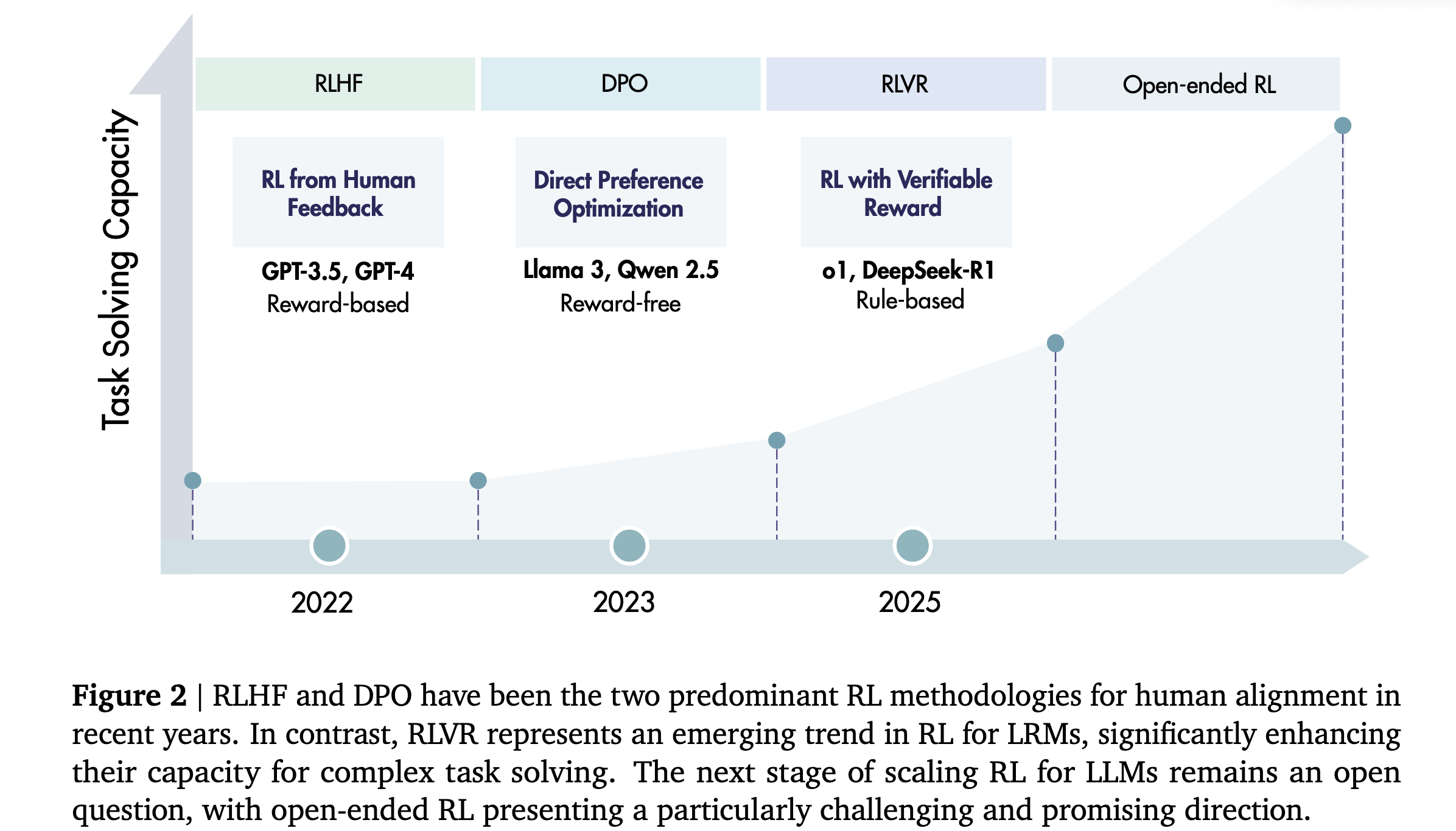

进入大模型时代后,RL 最初扮演的角色是“人类对齐” (Human Alignment) 这一后训练策略。这指的是让 LLM 的行为和回答更符合人类的价值观和偏好,使其变得更有用、更诚实、更无害(helpfulness, honesty, harmlessness 的 3H 原则) [cite: 75]。实现这一目标的两个主流技术是:

- 基于人类反馈的强化学习 (RLHF): 收集人类对模型不同回答的偏好排序,训练一个“奖励模型”来模仿人类的判断,再用这个奖励模型通过强化学习去微调 LLM [cite: 75]。

- 直接偏好优化 (DPO): 一种更直接的方法,它绕过了训练奖励模型的步骤,直接根据人类偏好数据来优化 LLM [cite: 75]。

新趋势:从“对齐”到“激励推理” (Incentivizing Reasoning)

前沿学术界最近出现了一个新的趋势:RL 的应用不再仅仅是为了“对齐”,而是为了主动地激励和训练模型自身的“推理”能力,即从 LLM 向 LRM(Large Reasoning Model)的转变。

这个趋势的两个里程碑式的模型是 OpenAI 的 o1 和 DeepSeek 的 DeepSeek-R1 [cite: 77]。它们采用了一种名为 RLVR (Reinforcement Learning with Verifiable Rewards) 的技术,即基于可验证奖励的强化学习 [cite: 77]。

- 什么是 RLVR? 与 RLHF 依赖主观的人类偏好不同,RLVR 使用的是客观、可被程序自动验证的奖励信号。例如:

- 在数学问题上,奖励就是最终答案是否正确 [cite: 77, 79]。

- 在代码生成任务中,奖励就是生成的代码能否通过单元测试 [cite: 77, 79]。

- RLVR 的意义:研究表明,通过这种方式训练,模型能够学会进行长链条的推理,甚至包括规划、反思和自我修正等高级能力 [cite: 77]。

新的缩放维度 (A New Scaling Axis)

传统上,提升模型能力主要依赖于两个缩放法则轴(Scaling Laws Axises)——增加预训练数据量和模型参数规模。而 RLVR 的成功揭示了一个全新的、与预训练正交的能力提升维度,这意味着即使在预训练完成后,依然有方法来持续提升模型的推理能力。这个新维度包含两个方面:

- 增加 RL 训练计算量 (Train-time compute):指的是在微调(or,后训练)阶段投入更多的计算资源进行强化学习训练。

- 一个典型的例子就是 DeepSeek-R1 所采用的 GRPO (Group Relative Policy Optimization) 策略 。GRPO 是一种无批评家 (critic-free) 的强化学习算法,它通过将一组候选答案的平均奖励作为基线来评估每个答案的优劣,从而简化了训练过程并提升了稳定性。具体来说,针对数学任务采用基于规则的显式准确性奖励,对编程任务则使用编译器或测试驱动的奖励机。

- DeepSeek-R1 的成功证明,大规模地应用 GRPO 这样的强化学习方法,可以在后续对齐阶段之前,直接在基础模型上“激发”出复杂的推理行为,而无需先进行指令微调 。

- 增加推理时计算量 (Test-time compute):这是 LRM 与 LLM 的核心区别,指的是模型在回答问题时,给予其更多的计算时间和资源去“思考”,即生成、评估和修改其思考链(Chain-of-Thought)。

LLM 训练生命周期

|

├── 1. 预训练 (Pre-training)

| └── 产出: 基础模型 (Base Model)

|

└── 2. 后训练 (Post-training) <--- “微调 (Fine-tuning)” 是这个阶段的泛称

|

├── 步骤 2a: 指令微调 (Instruction Fine-tuning / SFT)

| └── 产出: 指令/对话模型 (Instruct Model)

|

└── 步骤 2b: 强化学习训练 (Reinforcement Learning Training)

├── 方法1: RLHF (用于对齐)

├── 方法2: RLVR (用于推理)

└── 产出: 对齐后的模型 或 推理模型 (LRM)

此外,RL 还能通过自我生成数据(类似 AlphaGo 的自我对弈)来克服高质量训练数据不足的瓶颈。

综述的核心目标

随着 RL 在大模型推理上的应用越来越深入,也带来了算法设计、训练数据和基础设施等方面的新挑战。因此,这篇综述旨在系统性地回顾该领域的发展,探讨如何更好地扩展 RL 技术,以期实现更高级的人工智能。

Preliminaries

背景知识:如何将 LLM 视为一个 RL Agent?

要理解 RL 如何用于 LLM,首先需要了解 RL 的基本框架。

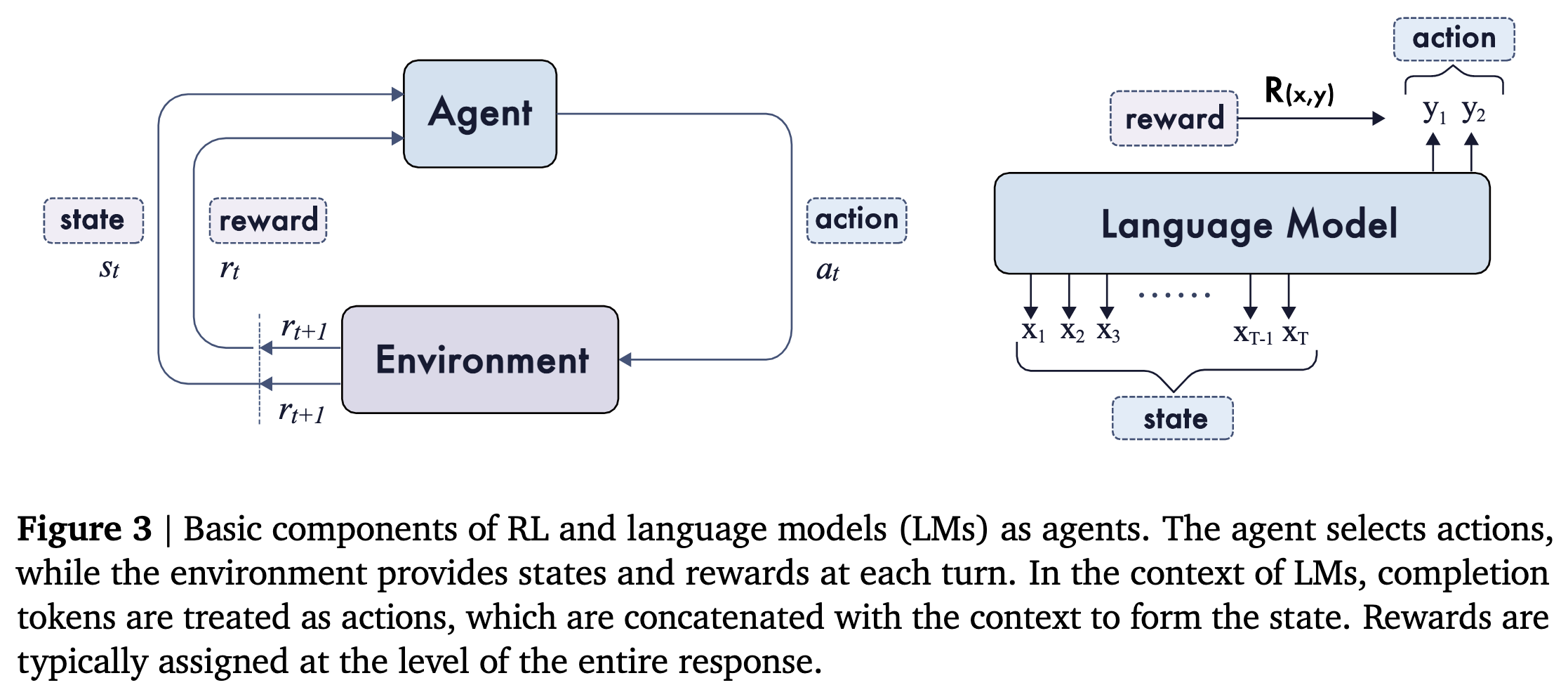

传统 RL 框架:

- 想象一个智能体(Agent)在一个环境(Environment)中学习。在每个时刻,智能体观察到当前的状态(State),然后根据策略(Policy)选择一个动作(Action)。执行动作后,环境会给它一个奖励(Reward),并转移到一个新的状态。智能体的目标是学习一个最优策略,从而最大化它能获得的累计奖励。

- 这个过程称为马尔科夫决策过程,即 MDP(Markov Decision Process)。MDP 通过一个五元组来定义,,主要组件包括状态空间 ,动作空间 ,状态转移函数 、奖励函数 以及折扣因子 。在每个时间步,智能体观测到状态 ,根据参数为 的策略 选择动作 ,获得奖励 ,并转移到下一状态 。可以通过下图左图来直观理解:

将 LLM 映射到 RL 框架:随着 RL 应用到 LLM 领域,这些概念需要稍作调整:

- 智能体 (Agent):就是语言模型本身 ,该模型根据当前状态及策略 生成下一个 token 的概率分布,最终生成一个长度为 的序列,记作 ,以响应提示。选择的策略与模型参数 相关。

- 环境(Environment):通常是用户给出的任务或提示( ),对应于从数据分布中抽取并与数据集 相对应的初始状态或环境上下文。

- 状态 ( ):指提示和到目前为止已生成的所有词元的拼接。例如, 。

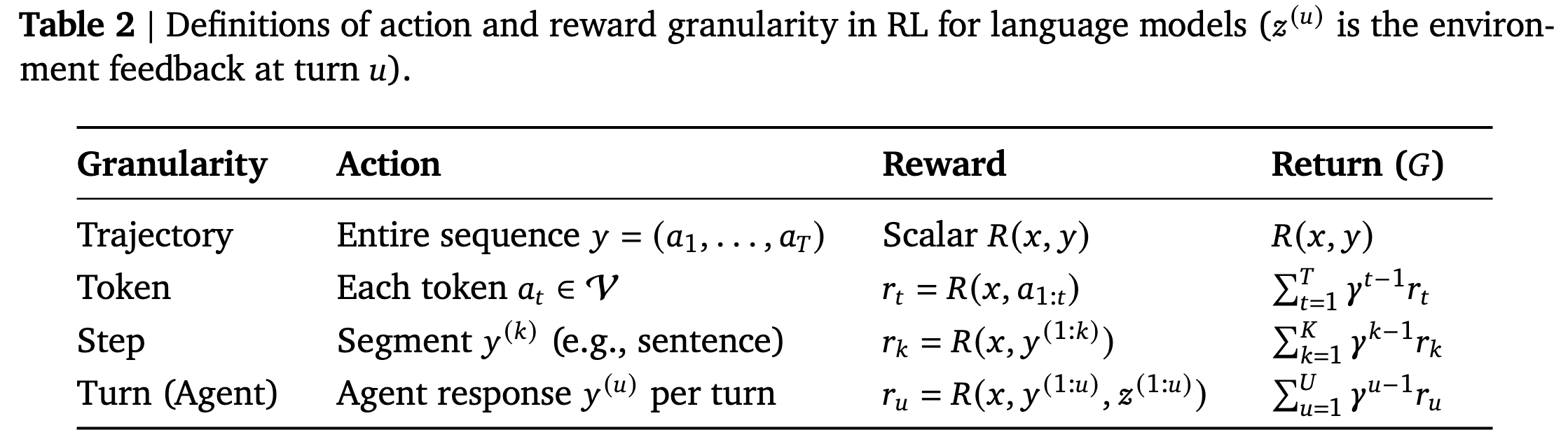

- 动作 ( ):模型在每一步生成的一个词元 (tokel-level),或者一个词元序列 (sequence-level),或者一个分段 (step-level)。

- 状态转移函数():在 LLM 的上下文中,状态转移通常是确定性的,因为 ,其中 表示字符串连接。当状态包含 EOS 标记时,策略会转移到终止状态,意味着轨迹结束(trajectory end)。

- 奖励 ( or ):通常在整个序列生成结束后(即模型输出完整答案后)给出。对于可验证任务,这个奖励可以是一个标量值,比如答案正确奖励为 +1,错误为 0 。并且根据动作的粒度分配奖励函数:例如在轨迹末端使用 seq-level 奖励 、每生成一个 token 使用 token-level 奖励 、或每生成一个片段使用 step-level 奖励 )。

- 返回值( ):对于提示 对应的完整轨迹 的累计奖励(在有限时间步下通常设 )。在 seq-level 奖励设定下可简化为单一标量,否则将聚合每词元/每步奖励,具体计算方式见上图表2。

学习目标:调整模型的参数 ,使得对于任何输入(数据分布服从 ),模型生成的回答能够获得期望累计奖励的最大化:

在实践中,通常会将学习到的策略向参考策略 进行正则化,常通过 KL 散度约束来实现,以稳定训练并保持语言质量。

[! note] 策略正则化与 KL 散度约束

1. 为什么需要将学习策略向参考策略正则化?(The “Why”)

在没有约束的情况下,强化学习的目标只有一个:最大化奖励。对于一个 LLM 来说,这可能会导致一些意想不到的严重问题:

- 语言能力退化 (Language Quality Degradation): 模型为了获得奖励,可能会找到一些“捷径”。比如,为了解对一道数学题,它可能会生成一些语法不通、逻辑混乱但最终答案碰巧正确的“怪异”文本。如果持续这样训练,模型原有的、通过预训练学来的流畅、自然的语言能力就会被破坏。这也是“灾难性遗忘” (Catastrophic Forgetting) 的一种表现。

- 策略坍塌与训练不稳定 (Policy Collapse & Instability): 模型可能会发现一个非常狭窄的、能稳定获得高奖励的回答模式,然后就只生成这种模式的文本。这会导致模型输出的多样性急剧下降,策略“坍塌”到一个局部最优解,从而失去泛化能力,使得训练过程非常不稳定。

2. 参考策略 () 是什么?怎样定义和获取?(The “What”)

参考策略 是一个固定的、我们认为表现良好的“基准”模型。它在 RL 训练过程中不参与更新,只作为被学习策略 的一个“锚点”或“参照物”。在实践中, 通常是以下几种模型之一:

- SFT 模型 (最常见):即经过指令微调(SFT)之后、但在进行强化学习训练之前的模型。这是最常用的参考策略。因为 SFT 模型已经学会了如何与用户进行流畅的对话和遵循指令,我们希望模型在通过 RL 学习新技能(如推理)时,不要忘记这些基本的对话能力。

- 预训练的基础模型 (Base Model):在某些情况下,也会使用原始的预训练基础模型作为参考,以确保模型的行为不会偏离其在预训练阶段学到的广泛知识基础。

- 旧策略 (): 还有一个相关的概念是 。它指的是进行当前梯度更新之前、若干步之前的那个策略模型。这主要用在 PPO 这类算法中,目的更多是为了控制单步更新的幅度,防止更新过快导致训练崩溃,与 保持语言质量的宏观目标略有不同,但都起到了稳定训练的作用。

3. KL 散度是什么?它如何进行约束?(The “How”)

KL 散度(Kullback-Leibler Divergence)是用来衡量两个概率分布之间差异性的一种数学工具。在 LLM 的情境下,这两个概率分布就是:

- P: 正在训练的模型(, learned policy)在看到一段文本后,预测下一个词的概率分布。

- Q: 参考模型(, reference policy)在看到相同的文本后,预测下一个词的概率分布。

- KL 散度值:

- 如果 KL 散度为 0,意味着两个分布完全相同,即我们的模型和参考模型的预测行为一模一样。

- 如果 KL 散度值很大,意味着两个分布差异巨大,我们的模型在预测下一个词时已经和参考模型“分道扬镳”了。

KL 散度如何进行约束? KL 散度是通过修改优化目标来实现约束的。原始的 RL 优化目标是: 。加入 KL 散度正则化后,优化目标变成了: 这个新的目标函数中, 是奖励项,它会驱动模型去学习新技能,以获得更高的分数; 是 KL 散度项,它计算了当前策略和参考策略之间的差异; 是一个超参数,它用来权衡奖励和惩罚的重要性。

这个新的目标函数非常巧妙:当模型为了追求高 Reward,其行为()开始大幅偏离参考策略()时,KL 散度项 就会急剧增大。这个增大的 KL 散度会变成一个巨大的惩罚项,从而拉低总的优化目标值。因此,优化算法(如梯度下降)为了最大化整个目标函数,就必须在“获得高奖励”和“保持低 KL 散度”之间找到一个平衡点。

前沿模型:现状

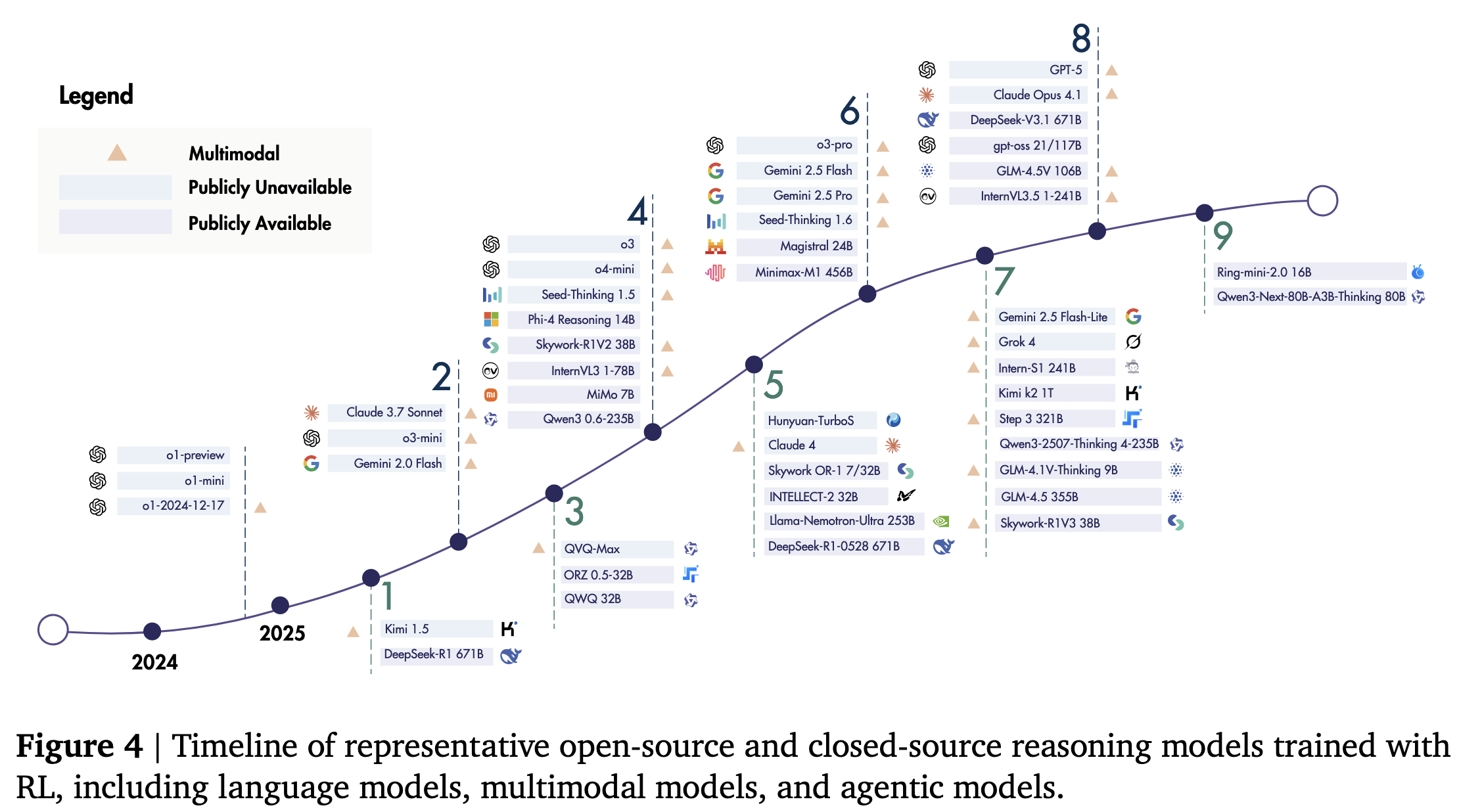

本节概述了自 o1 发布以来,通过类 RL 方法训练的前沿推理模型的发展情况。这些模型可以大致分为三个方向(如下图):

- 大型推理模型 (LRMs):

- 开创者: OpenAI 的 o1 证实了通过扩展训练阶段强化学习与测试阶段计算量可有效增强推理能力,在数学、编程和科学基准测试中取得领先成果;首个开源对标模型 DeepSeek-R1 采用多阶段训练流程确保模型能力全面发展,并探索了无需监督微调的纯强化学习路径(即零强化学习),它们验证了 RLVR 的有效性。

- 跟随者:

- 商业模型:Anthropic 公司的 Claude-3.7-sonnet 提出了混合推理特性,Googl 的 Gemini 2.0 与 2.5[Comanici et al., 2025]引入了更长上下文窗口,Seed-Thinking 1.5[Seed et al., 2025b]实现了跨领域泛化能力,o3 系列[OpenAI, 2025b]则展现出更先进的推理能力,更进一步地推出了 GPT-5 系列模型;

- 开源模型:千问系列的 QwQ-32B[Team, 2025g]达到 R1 性能水平,后续推出的 Qwen3 系列[Yang et al., 2025a]中代表模型 Qwen3-235B 进一步刷新基准成绩。Skywork-OR1 模型套件[He et al., 2025d]基于 R1 蒸馏模型,通过有效数据混合与算法创新实现可扩展的强化学习训练。Minimax-M1[Chen et al., 2025a]首创混合注意力机制以提升强化学习扩展效率。其他重要成果包括兼顾精度与效率的 Llama-Nemotron-Ultra[Bercovich et al., 2025]、无需既有模型蒸馏即可从零开始进行强化学习的 Magistral 24B[Rastogi et al., 2025],以及专注长上下文推理能力的 Seed-OSS[Team, 2025a]。

- 智能体模型 (Agentic LRMs):

- 随着推理能力的提升,模型也更擅长使用工具来完成任务。这类模型被优化用于执行智能体任务,例如 Claude-4.1-Opus 在智能体编程任务中拔得头筹,Kimi K2 专门针对智能体任务进行了优化,通过大规模智能体训练数据合成和适配不可验证奖励的通用强化学习流程实现了突破。随后发布的 GLM4.5 与 DeepSeek-V3.1 均重点强化了工具使用与智能体任务能力,在相关基准测试中展现出显著进步。

- 多模态模型 (Multimodal LRMs):

- 推理能力可以扩展到文本之外的模态,如图像、视频和音频。多数前沿闭源模型(包括 GPT-5、o3、Claude 和 Gemini 系列)均原生支持多模态。Gemini-2.5 特别强调了在文本、图像、视频和音频领域的强劲表现。

- 在开源领域,Kimi 1.5 代表了多模态推理的早期探索,其突出特点包括长上下文扩展以及文本与视觉领域的联合推理。QVQ 在视觉推理与分析思维方面表现卓越,而 Skywork R1V2 通过混合强化学习(同时采用 MPO 与 GRPO)实现了推理能力与通用能力的平衡。作为 InternVL 系列的重要扩充,InternVL3 采用了统一的原生多模态预训练阶段,后续的 InternVL3.5 则运用两阶段级联强化学习框架,实现了效率与多功能性的提升。近期发布的 Intern-S1 模型专注于跨领域多模态科学推理,通过在线强化学习期间采用混合奖励设计,有效促进了在广泛任务上的同步训练。其他新近模型包括 Step3 ——专为高效训练和最小化解码成本而设计,以及 GLM-4.5V ——在多数视觉多模态基准测试中达到最先进性能。

相关综述工作

在本小节中,我们比较了与强化学习和大语言模型相关的近期综述文献。部分综述主要聚焦于强化学习本身,涵盖经典强化学习及其最新扩展。Ghasemi 等人[2024]提出了涵盖算法与现实挑战的通用强化学习综述,Huh 与 Mohapatra[2023]专注于多智能体强化学习,Zhang 等人[2024b]回顾了自我博弈技术,Wu 等人[2025h]则综述了计算机视觉任务中的强化学习应用。尽管这些工作提供了强化学习的宏观视角,但均未明确探讨其在大型语言模型中的应用。

相比之下,另一些综述则以大语言模型及其新兴能力为核心,例如长链思维推理[Chen 等人, 2025m; Li 等人, 2025w; Xia 等人, 2024]和自适应行为[Feng 等人, 2025c; Sui 等人, 2025],这些研究通常将强化学习作为支撑这些进展的关键方法进行介绍。Zhao 等人[2023a]对大语言模型的架构与应用进行了宏观概述,而近期研究则特别聚焦于推理能力:Zhang 等人[2025a]综述了 DeepSeek-R1 发布后关于推理大语言模型的复现研究,Chen 等人[2025m]探讨了长链思维推理,Li 等人[2025w]分析了从系统 1 到系统 2 推理的转变。这些研究虽将基于强化学习的方法(如 RLHF 和 RLVR)列为有效工具,但仅将其视作众多推理策略中的组成部分。

Sun 等人[2025b]对基于基础模型的推理提出了更宏观的结构化见解,重点介绍了专门为推理提出或适配的基础模型,以及在多样化推理任务、方法论和基准测试方面的最新进展。Zhang 等人[2025b]研究了如何通过强化学习赋予大语言模型自主决策与自适应智能体能力。Xu 等人[2025a]的研究与我们的关注点更为接近,通过讨论大语言模型的强化推理,着重阐释了试错优化机制如何提升复杂推理能力。Wu[2025]则通过综述奖励模型与反馈学习策略对此视角进行了补充。然而,这些研究仍以推理性能或奖励设计为导向,未能系统性地整体探讨适用于大语言模型的强化学习方法。

Srivastava 与 Aggarwal[2025]代表了连接这两个领域的最新尝试,通过回顾用于大语言模型对齐与增强的强化学习算法(主要包含 RLHF[Christiano 等人, 2017]、RLAIF[Lee 等人, 2024b]和 DPO[Rafailov 等人, 2023]等方法),但其研究重心仍主要集中于模型对齐而非推理能力。

这部分内容将本篇综述与其他相关工作进行了区分。简单来说,之前的综述要么是宽泛地介绍强化学习,要么是探讨 LLM 的推理能力而将 RL 仅视为其中一种技术。而这篇综述的独特之处在于,它将强化学习置于中心位置,系统性地梳理了 RL 在 LLM 训练生命周期中的各个环节(奖励设计、策略优化、采样策略等)所扮演的角色,旨在为实现更强大的推理能力指明方向。

Fundamental Components

奖励设计

在本小节中,我们对大型推理模型强化学习的奖励设计进行全面探讨。首先在§3.1.1 讨论可验证奖励,这为研究提供了自然的起点。该方向已取得显著进展,以 DeepSeek-R1 的成功为典型例证,其通过可验证奖励机制证明了强化学习的可扩展性。相比之下,§3.1.2 研究生成式奖励,即通过模型参与验证或直接生成奖励信号。然而,可验证奖励与生成式奖励通常都表现为稀疏的数值反馈。奖励信号的密度是另一个重要维度,因此§3.1.3 探讨引入稠密奖励的方法。进一步的分类标准涉及奖励是来自外部真实值计算还是由模型直接估计,这一区别促使我们在§3.1.4 讨论无监督奖励。基于这四类方法,我们在§3.1.5 转向奖励塑造,分析如何组合或转换多样化奖励信号以促进学习。

Verifiable Rewards

这是当前大型推理模型(LRMs)训练中最主流、最成功的一种奖励设计。基于规则的奖励机制通过准确性验证与格式检查,为强化学习提供可扩展且可靠的训练信号,尤其在数学与编程任务中表现突出。

- 核心思路:奖励信号是客观的、非黑即白的,并且可以被一个程序或一组预设规则自动地、大规模地进行验证。这类任务通常满足“求解难,但验证易” (hard to solve, easy to verify) 的特点。

- 基于规则的奖励通过鼓励更长且更具反思性的思维链,可靠地提升数学与代码推理能力。该范式在 Tülu 中被形式化为 RLVR,用程序化验证器(programmatic verifier,如答案检查器或单元测试)替代学习型奖励模型。这类验证器在具有客观可验证结果的领域提供二元化可检验信号。类似的基于规则可验证奖励设计随后被整合进 DeepSeek 的训练流程:DeepSeek-V3 [Liu et al., 2024]针对确定性任务显式集成了基于规则的奖励系统,而 DeepSeek-R1 [Guo et al., 2025a]进一步采用了基于准确率和格式的奖励。

- Rule-based 🆚 outcome/process-based reward:基于规则的奖励与基于结果或基于过程的奖励模型形成对比,后者包括基于人类偏好排序训练的标准 RLHF 奖励模型,以及基于步骤级标注训练的过程奖励模型。DeepSeek-V3 与 DeepSeek-R1 表明,当扩展至大规模强化学习场景时,奖励模型可能遭遇奖励破解问题(reward hacking)1,而通过尽可能采用基于规则的奖励,可增强系统抗操纵性与鲁棒性,确保更高可靠性。实践中广泛使用两种基于规则的可验证奖励:

- 准确性奖励 (Accuracy rewards):主要用于数学和编程。例如,在数学题中,程序会自动检查模型在

\boxed{...}标记中输出的最终答案是否与标准答案一致。在编程题中,则通过运行单元测试来判断代码是否通过 (pass/fail)。 - 格式奖励 (Format rewards):对模型的输出结构进行约束。例如,强制要求模型将思考过程放在

<think>...</think>标签之间,而将回答放在<answer>...</answer>之中,这便于后续进行自动化的解析和验证。

- 准确性奖励 (Accuracy rewards):主要用于数学和编程。例如,在数学题中,程序会自动检查模型在

- Rule-based Verifier:基于规则的奖励通常源自基于规则的验证器,这类验证器依赖大量人工编写的等价规则来判断预测答案是否与标准答案匹配。当前广泛使用的数学验证器主要基于 Python 库 Math-Verify1 和 SymPy2 构建。此外,部分研究如 DAPO [Yu et al., 2025d]和 DeepScaleR [Luo et al., 2025c]也提供了开源且成熟的验证器。最近,Huang 等人[2025e]指出了基于规则和基于模型的验证器各自存在的独特局限性,为设计更可靠的奖励系统提供了参考。

- Verifier’s Law:验证器定律指出:训练 AI 系统执行任务的难易程度与任务可验证程度成正比。该定律强调,当任务能配备稳健的自动化反馈时,即可通过强化学习实现快速改进。第 6 章讨论的成功应用案例证实了该原则,这些案例的核心挑战均在于设计可靠的可验证反馈机制。反之,第 7 章强调的许多开放性问题,正是由于缺乏可靠的自动化奖励而产生的。

- 优点:

- 可靠且可扩展 (Reliable & Scalable):由于奖励是客观规则生成的,所以信号非常稳定、可靠,不会像人类标注那样存在主观偏差,非常适合进行大规模训练。

- 抗奖励作弊 (Resistant to Reward Hacking):模型很难通过钻空子的方式来“欺骗”一个明确的规则(比如单元测试),这比欺骗一个可能存在漏洞的、学习出来的奖励模型要困难得多。

- 缺点/挑战:

- 应用领域有限:这是其最大的缺点。它只能用于那些有确定性、客观结果的领域(如数学、代码、逻辑题),而无法用于开放式问答、创意写作等主观性强的任务。

Generative Rewards

为了解决可验证奖励的局限性,研究者们提出了生成式奖励,旨在将 RL 扩展到主观、非验证领域。

- 核心思路:不再满足于给出一个简单的数字分数,而是利用一个强大的 LRM(通常被称为“法官模型”)来生成结构化的、带有自然语言解释的细致的评价、推理依据、批评或偏好判断,以此作为更具可解释性与细致度的奖励信号。

- 基于模型的验证器:基于规则系统的主要挑战在于其脆弱性——当模型以意外格式生成正确答案时,常会产生假阴性结果。为缓解此问题,一项研究方向采用基于规范的生成式推理模型(GenRM)作为灵活的模型化验证器。这类模型经过训练,能够从语义层面评估模型自由形式输出与参考答案的等价性。通过用习得的语义判断替代或补充僵化的字符串匹配,这些验证器为可验证领域的强化学习提供了更精确的奖励信号。

- 具体方法与例子:

- 推理奖励模型 (Reasoning Reward Models,Learn to think):这是 “LLM-as-a-Judge” 思想的体现。奖励模型在给出最终分数前,会先生成一段“思考链”(CoT)进行显式推理,解释它为什么会给出这个分数(更准确地说,这是在将奖励建模 reward modeling 视作推理任务 reasoning task,这条原则已是 sota 推理模型的核心范式)。这种“先思考再判断”的模式让奖励信号更具说服力和可解释性。为持续提升判断能力,这类推理奖励模型本身也常通过强化学习进行训练,并基于最终结论正确性采用可验证的元奖励机制[Chen et al., 2025l, Whitehouse et al., 2025]。该研究方向还探索了不同的奖励形式,包括从词元概率推导软奖励[Mahan et al., 2024, Su et al., 2025c, Zhang et al., 2024a],以及权衡点式评分与配对评分方案的优劣[He et al., 2025a, Xu et al., 2025c]。

- 基于准则的奖励 (Rubric-based Rewards,结构化主观性):为了让主观评价更稳定,研究者会设计一套详细的评估准则(Rubric),让“法官模型”依据这个准则清单来打分,从而使评价更加细粒度和一致。

- 共同进化系统 (Co-Evolving Systems):这是一个更高级的范式,即策略模型(“选手”)和奖励模型(“裁判”)不再是固定的,而是在训练循环中共同学习、共同进步。一个典型的例子是“自我奖励”(Self-Rewarding),即模型自己扮演自己的裁判,生成反馈来指导自身的优化。

- 优点:

- 打破领域限制:核心优势在于它能将强化学习的应用扩展到几乎所有领域,尤其是那些没有标准答案的主观任务。

- 提供更丰富的反馈:相比一个冷冰冰的数字,一段自然的语言批评能为模型的优化提供更细致、更具指导性的信息。

- 缺点/挑战:

- “法官”的局限性:奖励的质量完全取决于“法官模型”的能力。如果法官模型本身存在偏见或能力不足,就会产生误导性的奖励信号。

生成式奖励在不可验证任务中的应用。生成式奖励模型的另一核心应用是基于评估的生成式奖励模型,该模型使得强化学习能够应用于不满足验证者定律的任务场景。该范式已从使用强大语言模型作为零样本评估器,发展为复杂的协同进化系统。我们可以根据其核心设计原则对这些方法进行分类。

- 基于量规的奖励(结构化主观性):为使主观任务的评估锚定于更统一的标准,许多框架采用结构化量规。与依赖硬编码逻辑处理客观可验证任务的基于规则方法不同,基于量规的方法利用自然语言描述来捕捉主观不可验证领域的细微评估标准——这些领域传统二元规则将不再适用。该方法通过使用大语言模型生成或遵循原则清单来指导评估。诸如RaR [Gunjal et al., 2025]、QA-LIGN [Dineen et al., 2025]、Rubicon [Huang et al., 2025f]和RLCF [Viswanathan et al., 2025]等框架均采用此类量规来生成细粒度、多维度的奖励。该概念可延伸至将高层任务分解为一系列可验证的代理问题[Guo et al., 2025e],或生成特定领域原则(如创意写作[Jia et al., 2025]或科学评审[Zeng et al., 2025c])。此外,量规可兼具双重功能:既作为指导策略探索的教学支架,又作为最终奖励的评判标准[Zhou et al., 2025f]。

Dense Rewards

无论是可验证奖励还是生成式奖励,通常都是在模型生成完整回答后才给出,这被称为“稀疏奖励”。密集奖励则试图解决由此带来的问题。

-

核心思路:在模型的推理过程中,对其每一步或每一个中间环节提供反馈,而不是只评价最终结果 16161616。

-

解决的问题:信用分配 (Credit Assignment)。对于一个很长的推理链,如果最终答案错了,模型很难知道到底是哪一步出了问题。密集奖励就像一位老师,能在学生算错某一步时立刻指出来。

-

具体方法(按粒度划分):

-

词元级 (Token-Level):为模型生成的每一个 token 提供奖励 17。

-

步骤级 (Step-Level):为推理过程中的每一个步骤(如一个公式、一句话)提供奖励 18。这通常需要一个“过程奖励模型”(PRM) 来对中间步骤进行打分。

-

轮次级 (Turn-Level):在多轮交互任务(如使用工具)中,为每一轮交互(如一次工具调用)提供奖励 19。

-

-

优点:

- 提升训练效率和稳定性:高频的反馈可以显著加速模型的学习过程,让训练更稳定 20202020。

-

缺点/挑战:

-

标注成本极高:要获得高质量的步骤级人工标注,成本非常高昂,难以规模化 21。

-

设计不当易导致作弊:如果中间步骤的奖励设计得不好,模型可能会学会“只刷过程分”,而忽略了最终的目标,导致“奖励作弊” 22。

-

3.1.4 Unsupervised Rewards (无监督奖励)

这种思路旨在完全摆脱对人类标注或预定义规则的依赖,实现奖励信号的自动化生成。

-

核心思路:不依赖任何外部的真实标签(ground-truth)或人类反馈,仅从模型自身或无标签数据中挖掘出奖励信号 23。其终极目标是让奖励的规模不再受限于人力,而是受限于算力 2424。

-

具体方法与例子:

-

模型特定的奖励 (Model-Specific):从模型自身的行为中提取信号 25。

-

输出一致性: 让模型对同一个问题生成多个答案,并假设出现次数最多的那个答案是正确的,以此为基础给予奖励(少数服从多数) 26。

-

内部置信度: 利用模型内部的状态(如输出概率、token 熵)作为其“自信程度”的代理,自信程度高的被认为是正确的 27。

-

自我生成知识: 模型自己扮演“出题人”和“裁判”,自主生成任务并进行评价 28。

-

-

模型无关的奖励 (Model-Agnostic):从外部自动化来源获取信号 29。

- 启发式奖励: 使用一些简单的启发式规则,比如回答的长度、是否包含特定关键词等作为奖励 30。

-

-

优点:

- 极强的可扩展性:彻底解决了人工标注的瓶颈,理论上可以无限生成训练信号 31313131。

-

缺点/挑战:

-

易陷入自我循环的错误:模型可能会不断强化自己错误的认知或偏见,导致“模型坍塌” 32323232。

-

信号噪声大且易作弊:基于启发式规则或一致性的奖励通常很嘈杂,且容易被模型找到漏洞并作弊 33。

-

3.1.5 Reward Shaping (奖励塑造)

奖励塑造更像是一种“元策略”,它不对奖励的来源做规定,而是关注如何对已有的奖励信号进行加工和改造。

-

核心思路:通过组合、变换或调整现有的奖励函数,来生成一个更平滑、信息量更丰富的奖励信号,以更好地引导模型学习 34。

-

具体方法与例子:

-

基于规则的奖励塑造:用一个公式将不同来源的奖励组合起来。例如,最终奖励 =

(准确性奖励) +

(格式奖励) +

(奖励模型分数)。这种方法可以平衡不同方面的优化目标 35。

-

基于结构的奖励塑造:奖励的计算不再只看单个样本,而是基于一组候选样本的集体表现。

- GRPO 是最典型的例子。它不是直接使用原始奖励

R(y),而是使用一个相对优势R(y) - mean(R_group)。这意味着,一个回答只有比同一组的其他回答的平均表现更好时,才会得到正向激励。这极大地稳定了训练过程 36。

- GRPO 是最典型的例子。它不是直接使用原始奖励

-

-

优点:

-

稳定训练梯度:将稀疏的 0/1 奖励信号变得更平滑、更有层次,为模型优化提供了更有效的梯度 37。

-

鼓励有效探索:通过更精细的奖励设计,可以鼓励模型探索更多样化且有价值的解法,避免过早地收敛到局部最优解 38。

-

总结一下,这五种奖励设计思路各有侧重,形成了一个从客观到主观、从稀疏到密集、从有监督到无监督的完整图景。在实际应用中,它们常常被组合使用,例如,在一个任务中同时使用可验证的准确性奖励和基于规则的长度惩罚,并通过 GRPO 的结构化方式进行塑造。理解这些设计的权衡是进行高效 RL 训练的关键。

Footnotes

-

当 强化学习 (RL) AI 智能体 利用 奖励函数中的缺陷或歧义来获得高奖励,而没有真正学习或完成预期的任务时,就会发生reward hacking。reward hacking的存在是因为 RL 环境通常是不完善的,并且准确地指定奖励函数从根本上具有挑战性。Reward Hacking in Reinforcement Learning | Lil’Log ↩